Google zieht Gemma AI aus AI Studio zurück und bekräftigt angesichts von Genauigkeitsbedenken den ausschließlichen Entwicklerzweck.

In Kürze Google hat sein Gemma-Modell nach Berichten über Halluzinationen bei der Beantwortung von Faktenfragen zurückgezogen. Das Unternehmen betonte, dass es für Entwickler- und Forschungszwecke gedacht sei.

Technologieunternehmen Google Das Unternehmen kündigte die Rücknahme seines Gemma-KI-Modells an, nachdem Berichte über ungenaue Antworten auf sachliche Fragen eingegangen waren, und stellte klar, dass das Modell ausschließlich für Forschungs- und Entwicklerzwecke konzipiert worden sei.

Laut Unternehmensangaben ist Gemma nicht mehr über AI Studio zugänglich, steht Entwicklern aber weiterhin über die API zur Verfügung. Anlass für diese Entscheidung waren Fälle, in denen Nicht-Entwickler Gemma über AI Studio nutzten, um Fakten abzurufen, was nicht der vorgesehenen Funktion entsprach.

Google erklärte, Gemma sei nie als Tool für Endverbraucher gedacht gewesen, und die Entfernung erfolge, um weitere Missverständnisse hinsichtlich seines Zwecks zu vermeiden.

In seiner Klarstellung betonte Google, dass die Gemma-Modellfamilie als Open-Source-Werkzeuge zur Unterstützung der Entwickler- und Forschungsgemeinschaft entwickelt wurde und nicht zur Bereitstellung von Fakten oder zur Interaktion mit Endnutzern. Das Unternehmen merkte an, dass offene Modelle wie Gemma Experimente und Innovationen fördern sollen, indem sie Nutzern ermöglichen, die Modellleistung zu untersuchen, Probleme zu identifizieren und wertvolles Feedback zu geben.

Google hob hervor, dass Gemma bereits zu wissenschaftlichen Fortschritten beigetragen hat, und nannte als Beispiel das Gemma C2S-Scale 27B-Modell, das kürzlich eine Rolle bei der Identifizierung eines neuen Ansatzes für die Entwicklung von Krebstherapien spielte.

Das Unternehmen räumte ein, dass die KI-Branche auch mit umfassenderen Herausforderungen konfrontiert ist, wie etwa Halluzinationen – wenn Modelle falsche oder irreführende Informationen erzeugen – und Schmeichelei – wenn sie zwar angenehme, aber ungenaue Antworten liefern.

Diese Probleme treten besonders häufig bei kleineren offenen Modellen auf wie Gemma Google bekräftigte sein Engagement, Halluzinationen zu reduzieren und die Zuverlässigkeit und Leistungsfähigkeit seiner KI-Systeme kontinuierlich zu verbessern.

Google setzt mehrschichtige Strategie ein, um KI-Halluzinationen einzudämmen

Das Unternehmen verfolgt einen mehrstufigen Ansatz, um Halluzinationen in seinen großen Sprachmodellen (LLMs) zu minimieren. Dieser kombiniert Datenfundierung, rigoroses Training und Modelldesign, strukturierte Eingabeaufforderungen und Kontextregeln sowie kontinuierliche menschliche Überwachung und Feedbackmechanismen. Trotz dieser Maßnahmen räumt das Unternehmen ein, dass Halluzinationen nicht vollständig ausgeschlossen werden können.

Die grundlegende Einschränkung ergibt sich aus der Funktionsweise von LLMs. Anstatt die Wahrheit zu verstehen, funktionieren diese Modelle, indem sie wahrscheinliche Wortfolgen auf Basis von während des Trainings identifizierten Mustern vorhersagen. Fehlt dem Modell eine ausreichende Grundlage oder trifft es auf unvollständige oder unzuverlässige externe Daten, kann es Antworten generieren, die zwar glaubwürdig klingen, aber faktisch falsch sind.

Google weist zudem darauf hin, dass die Optimierung der Modellleistung mit gewissen Zielkonflikten verbunden ist. Erhöhte Vorsicht und eingeschränkte Ergebnisse können zwar Fehlinterpretationen reduzieren, gehen aber oft auf Kosten von Flexibilität, Effizienz und Nützlichkeit bei bestimmten Aufgaben. Daher können gelegentlich Ungenauigkeiten auftreten, insbesondere in neuen, spezialisierten oder unterrepräsentierten Bereichen mit begrenzter Datenabdeckung.

Haftungsausschluss: Der Inhalt dieses Artikels gibt ausschließlich die Meinung des Autors wieder und repräsentiert nicht die Plattform in irgendeiner Form. Dieser Artikel ist nicht dazu gedacht, als Referenz für Investitionsentscheidungen zu dienen.

Das könnte Ihnen auch gefallen

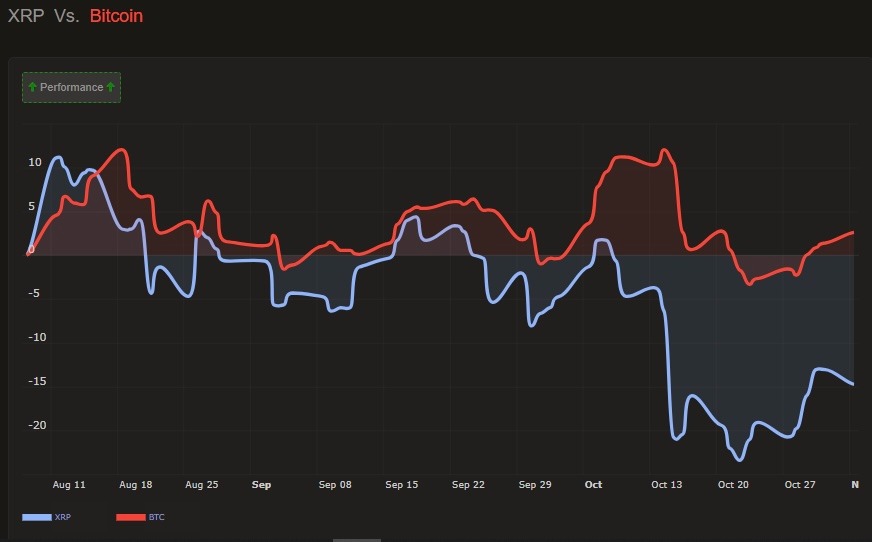

„XRPs Weg besteht nicht darin, Bitcoin zu folgen“: Analyst erläutert Entkopplungsthese

Solana-Preisprognose: SOL-Markt schwächt sich trotz steigendem Open Interest vor November ab

Der neue DAT-Bericht von CertiK: „Wie Sie Kryptowährungen halten“ ist jetzt wichtiger als „Was Sie halten“