Del aprendizaje federado a la red de agentes descentralizados: análisis del proyecto ChainOpera

Este informe explora ChainOpera AI, un ecosistema diseñado para construir una red descentralizada de AI Agents. El proyecto evolucionó a partir del código abierto de aprendizaje federado (FedML), se actualizó a una infraestructura de IA de pila completa a través de TensorOpera y finalmente evolucionó hacia ChainOpera, una red de agentes orientada a Web3.

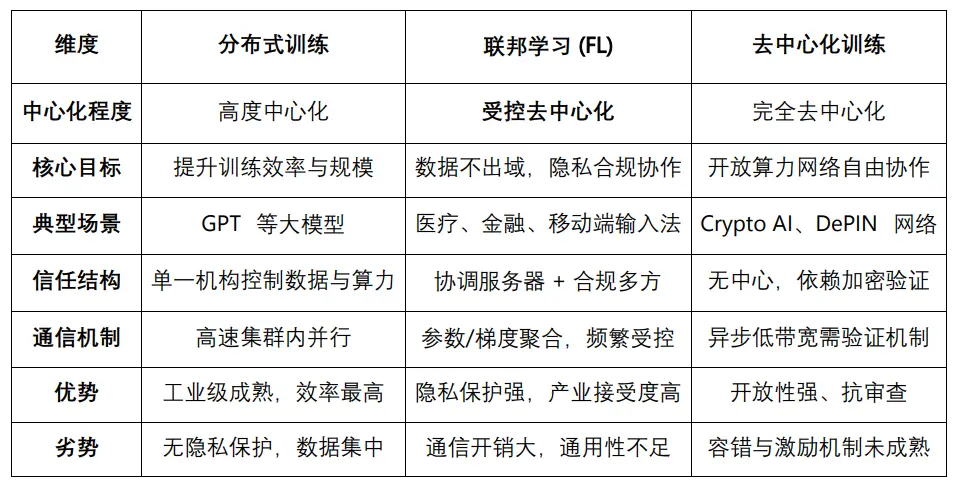

En el informe de junio “ El Santo Grial de la Crypto AI: Exploración de la vanguardia del entrenamiento descentralizado ”, mencionamos el aprendizaje federado (Federated Learning), una solución de “descentralización controlada” que se sitúa entre el entrenamiento distribuido y el entrenamiento descentralizado: su núcleo es la retención local de datos y la agregación centralizada de parámetros, satisfaciendo las necesidades de privacidad y cumplimiento en sectores como la medicina y las finanzas. Al mismo tiempo, en informes anteriores hemos seguido de cerca el auge de las redes de agentes (Agent Network), cuyo valor radica en la colaboración autónoma y la división de tareas entre múltiples agentes para completar tareas complejas, impulsando la evolución de los “grandes modelos” hacia un “ecosistema de agentes múltiples”.

El aprendizaje federado, basado en “los datos no salen del entorno local y las recompensas se otorgan según la contribución”, sienta las bases para la colaboración multipartita. Sus genes distribuidos, incentivos transparentes, protección de la privacidad y prácticas de cumplimiento ofrecen experiencias directamente reutilizables para las Agent Network. El equipo de FedML sigue esta línea, evolucionando su código abierto hacia TensorOpera (capa de infraestructura industrial de IA), y posteriormente hacia ChainOpera (red descentralizada de agentes). Por supuesto, la Agent Network no es una extensión inevitable del aprendizaje federado; su núcleo reside en la colaboración autónoma y la división de tareas entre múltiples agentes, y también puede construirse directamente sobre sistemas multiagente (MAS), aprendizaje por refuerzo (RL) o mecanismos de incentivos basados en blockchain.

I. Arquitectura de la pila tecnológica de Aprendizaje Federado y AI Agent

El aprendizaje federado (Federated Learning, FL) es un marco de entrenamiento colaborativo sin centralizar los datos. Su principio básico es que cada participante entrena el modelo localmente y solo sube los parámetros o gradientes a un coordinador para su agregación, logrando así el cumplimiento de la privacidad bajo el principio de “los datos no salen del dominio”. Tras su aplicación en escenarios típicos como medicina, finanzas y dispositivos móviles, el aprendizaje federado ha entrado en una etapa comercial relativamente madura, aunque sigue enfrentando cuellos de botella como altos costes de comunicación, protección de la privacidad incompleta y baja eficiencia de convergencia debido a la heterogeneidad de los dispositivos. Comparado con otros modos de entrenamiento, el entrenamiento distribuido enfatiza la concentración de poder de cómputo para buscar eficiencia y escala, el entrenamiento descentralizado logra colaboración completamente distribuida a través de redes abiertas de cómputo, mientras que el aprendizaje federado se sitúa entre ambos, representando una “descentralización controlada”: satisface las necesidades de privacidad y cumplimiento de la industria y ofrece una vía factible para la colaboración interinstitucional, siendo más adecuado como arquitectura de despliegue transitoria en el sector industrial.

En toda la pila de protocolos de AI Agent, en informes previos la hemos dividido en tres niveles principales, a saber:

-

Capa de infraestructura (Agent Infrastructure Layer): Esta capa proporciona el soporte operativo más básico para los agentes y es la base técnica de todos los sistemas de agentes.

-

Módulos principales: Incluyen el Agent Framework (marco de desarrollo y ejecución de agentes) y el Agent OS (sistema operativo de múltiples tareas y ejecución modular a nivel más bajo), proporcionando capacidades clave para la gestión del ciclo de vida de los agentes.

-

Módulos de soporte: Como Agent DID (identidad descentralizada), Agent Wallet & Abstraction (abstracción de cuentas y ejecución de transacciones), Agent Payment/Settlement (capacidades de pago y liquidación).

-

Capa de coordinación y ejecución (Coordination & Execution Layer)se centra en la colaboración entre múltiples agentes, la programación de tareas y los mecanismos de incentivos del sistema, siendo clave para construir la “inteligencia colectiva” de los sistemas de agentes.

-

Agent Orchestration: Es el mecanismo de dirección, utilizado para la programación y gestión unificada del ciclo de vida de los agentes, la asignación de tareas y los flujos de ejecución, adecuado para escenarios de flujo de trabajo con control centralizado.

-

Agent Swarm: Es una estructura de colaboración, enfatiza la cooperación distribuida entre agentes, con alta autonomía, capacidad de división de tareas y colaboración flexible, adecuada para tareas complejas en entornos dinámicos.

-

Agent Incentive Layer: Construye el sistema de incentivos económicos de la red de agentes, motivando a desarrolladores, ejecutores y validadores, proporcionando un motor sostenible para el ecosistema de agentes.

-

Capa de aplicación (Application & Distribution Layer)

-

Subclase de distribución:Incluye Agent Launchpad, Agent Marketplace y Agent Plugin Network

-

Subclase de aplicación:Cubre AgentFi, Agent Native DApp, Agent-as-a-Service, etc.

-

Subclase de consumo:Principalmente Agent Social / Consumer Agent, orientado a escenarios ligeros de consumo y socialización.

-

Meme:Utiliza el concepto de Agent para especulación, carece de implementación técnica real y aplicaciones prácticas, impulsado solo por el marketing.

II. FedML como referente en aprendizaje federado y la plataforma full-stack TensorOpera

FedML es uno de los primeros marcos de código abierto orientados al aprendizaje federado (Federated Learning) y entrenamiento distribuido, originado en un equipo académico (USC) y gradualmente convertido en el producto central de TensorOpera AI. Proporciona a investigadores y desarrolladores herramientas de entrenamiento colaborativo de datos entre instituciones y dispositivos. En el ámbito académico, FedML es una plataforma experimental común para la investigación en aprendizaje federado, frecuentemente citada en conferencias como NeurIPS, ICML y AAAI; en la industria, FedML goza de buena reputación en escenarios sensibles a la privacidad como medicina, finanzas, edge AI y Web3 AI, siendo considerado la herramienta de referencia en el campo del aprendizaje federado.

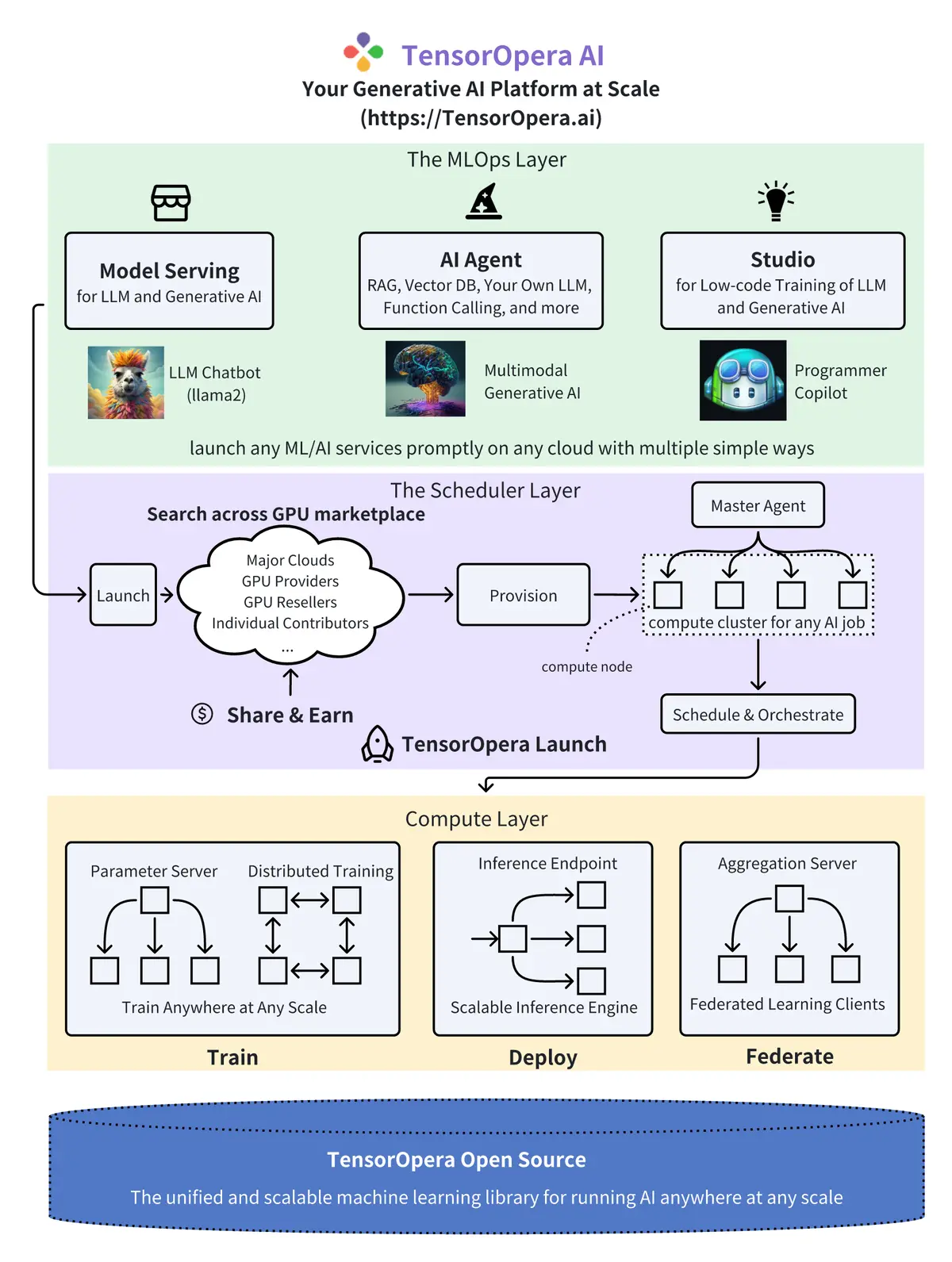

TensorOpera es la evolución comercial de FedML hacia una plataforma de infraestructura AI full-stack para empresas y desarrolladores: manteniendo las capacidades de aprendizaje federado, se expande a GPU Marketplace, servicios de modelos y MLOps, accediendo así a un mercado más amplio en la era de los grandes modelos y los agentes. La arquitectura general de TensorOpera se divide en tres capas: Compute Layer (capa base), Scheduler Layer (capa de programación) y MLOps Layer (capa de aplicación):

1. Compute Layer (capa base)

La capa Compute es la base técnica de TensorOpera, heredando el código abierto de FedML. Sus funciones principales incluyen Parameter Server, Distributed Training, Inference Endpoint y Aggregation Server. Su valor radica en proporcionar entrenamiento distribuido, aprendizaje federado con protección de privacidad y un motor de inferencia escalable, soportando las tres capacidades clave de “Train / Deploy / Federate”, cubriendo toda la cadena desde el entrenamiento y despliegue de modelos hasta la colaboración entre instituciones, siendo la base de toda la plataforma.

2. Scheduler Layer (capa intermedia)

La capa Scheduler es el centro de negociación y programación de poder de cómputo, compuesta por GPU Marketplace, Provision, Master Agent y Schedule & Orchestrate, soportando la utilización de recursos entre nubes públicas, proveedores de GPU y contribuyentes independientes. Esta capa es el punto de inflexión clave en la evolución de FedML a TensorOpera, permitiendo entrenamiento e inferencia AI a mayor escala mediante programación inteligente de recursos y orquestación de tareas, cubriendo escenarios típicos de LLM y AI generativa. Además, el modo Share & Earn de esta capa reserva interfaces de incentivos, con potencial de compatibilidad con DePIN o modelos Web3.

3. MLOps Layer (capa superior)

La capa MLOps es la interfaz de servicio directa para desarrolladores y empresas, incluyendo módulos como Model Serving, AI Agent y Studio. Las aplicaciones típicas cubren chatbots LLM, AI generativa multimodal y herramientas Copilot para desarrolladores. Su valor radica en abstraer el poder de cómputo y las capacidades de entrenamiento subyacentes en APIs y productos de alto nivel, reduciendo la barrera de entrada, proporcionando agentes listos para usar, entornos de desarrollo low-code y capacidades de despliegue escalables, posicionándose frente a plataformas de nueva generación como Anyscale, Together, Modal, etc., actuando como puente entre la infraestructura y las aplicaciones.

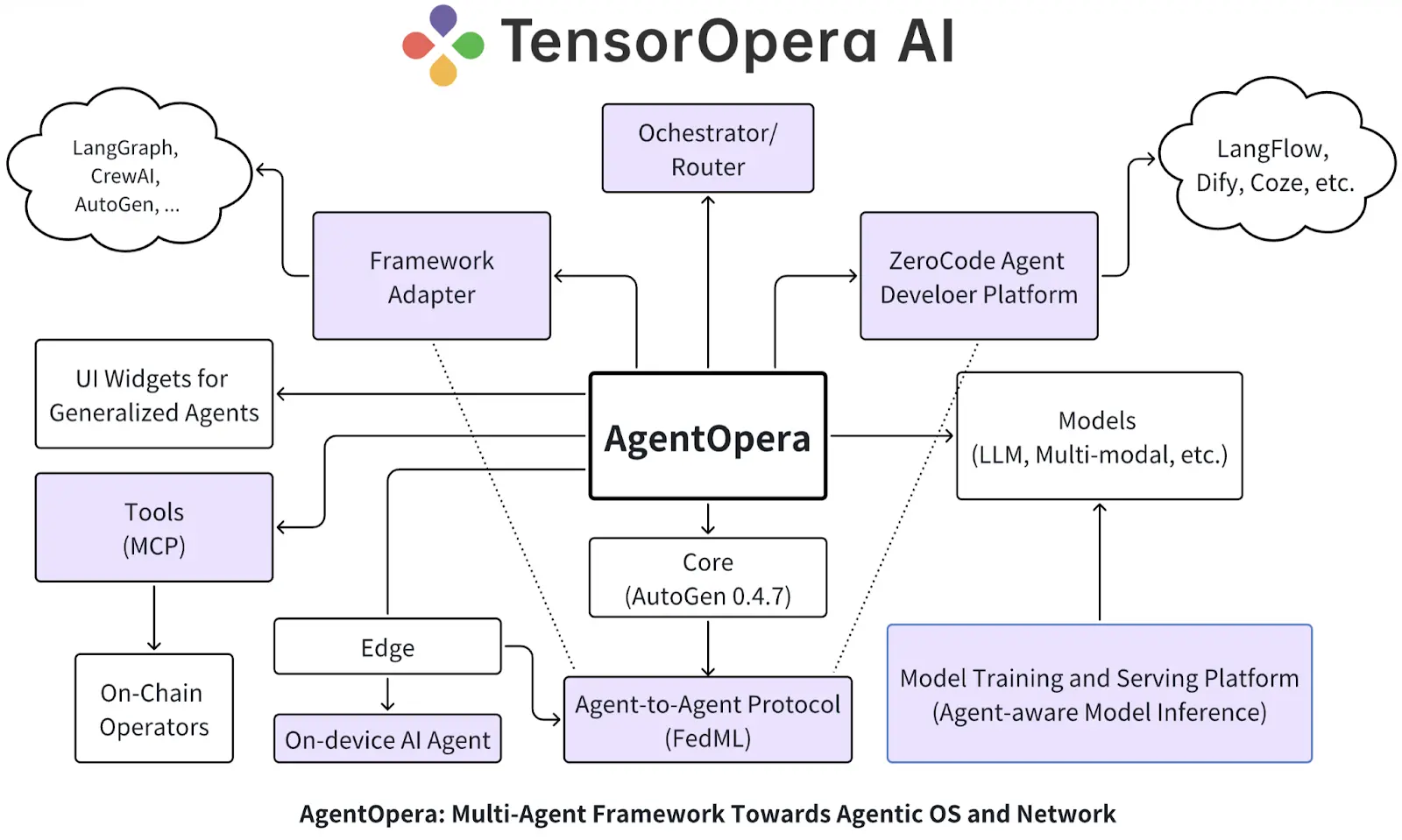

En marzo de 2025, TensorOpera se actualiza a una plataforma full-stack orientada a AI Agent, con productos principales que incluyen AgentOpera AI App, Framework y Platform. La capa de aplicación ofrece una entrada multiagente tipo ChatGPT, la capa de framework evoluciona hacia un “Agentic OS” basado en sistemas multiagente de estructura gráfica y Orchestrator/Router, y la capa de plataforma se integra profundamente con la plataforma de modelos TensorOpera y FedML, logrando servicios de modelos distribuidos, optimización RAG y despliegue híbrido edge-cloud. El objetivo general es construir “un sistema operativo, una red de agentes”, permitiendo que desarrolladores, empresas y usuarios co-construyan la nueva generación de ecosistemas Agentic AI en un entorno abierto y con protección de privacidad.

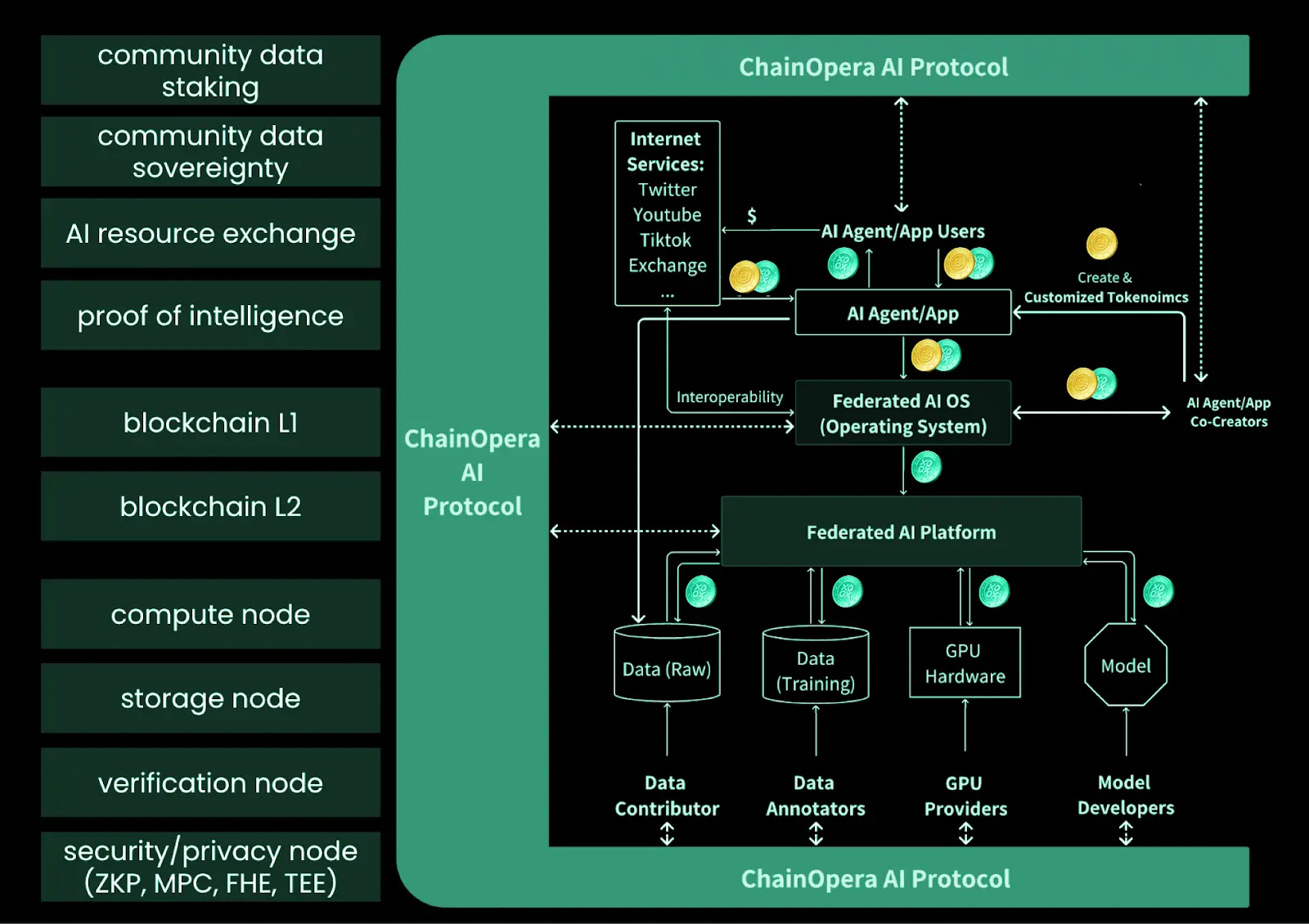

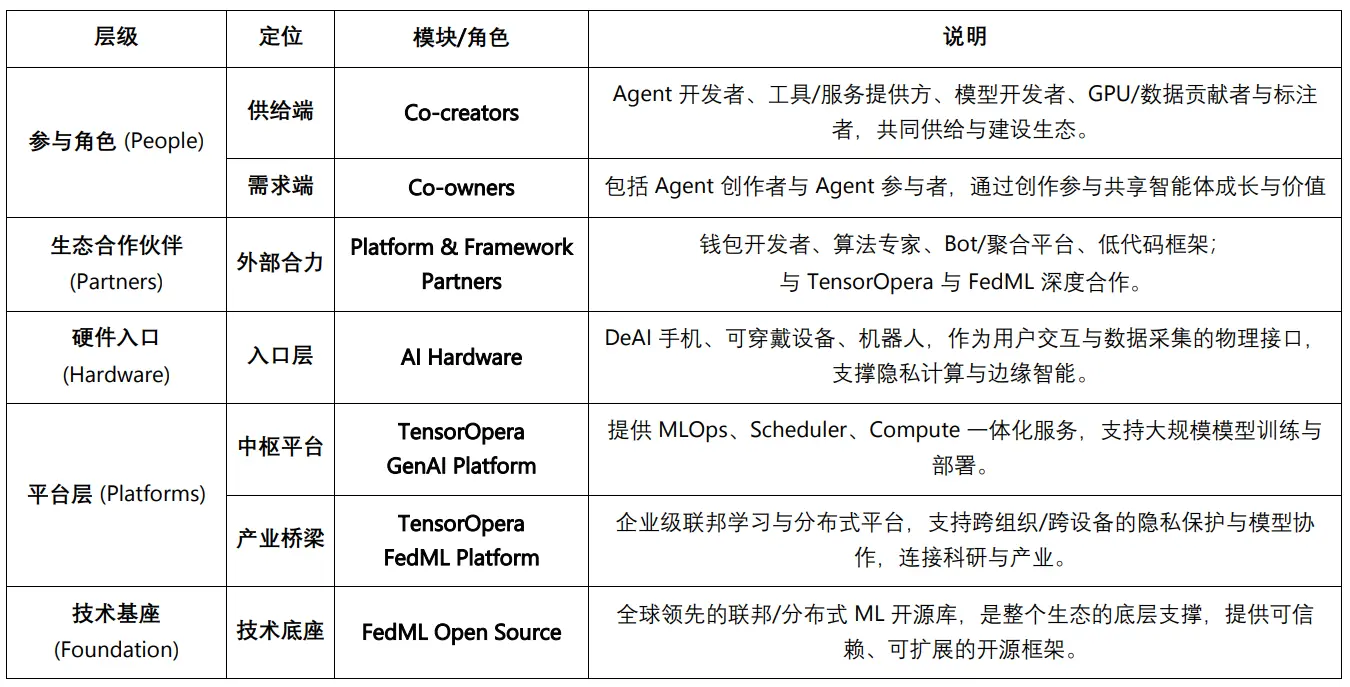

III. Panorama del ecosistema ChainOpera AI: de co-creadores y co-propietarios a la base tecnológica

Si FedML es el núcleo técnico que proporciona el código abierto de aprendizaje federado y entrenamiento distribuido; TensorOpera abstrae los logros científicos de FedML en una infraestructura AI full-stack comercializable, entonces ChainOpera es la “on-chainización” de las capacidades de plataforma de TensorOpera, construyendo una red descentralizada de agentes mediante AI Terminal + Agent Social Network + modelo y capa de cómputo DePIN + blockchain AI-Native. El cambio clave es que TensorOpera sigue orientado principalmente a empresas y desarrolladores, mientras que ChainOpera, mediante gobernanza e incentivos Web3, integra a usuarios, desarrolladores y proveedores de GPU/datos en la co-construcción y co-gobernanza, haciendo que los AI Agent no solo sean “utilizados”, sino también “co-creados y co-propiedad”.

Ecosistema de co-creadores (Co-creators)

ChainOpera AI, a través de Model & GPU Platform y Agent Platform, proporciona herramientas, infraestructura y capa de coordinación para la co-creación del ecosistema, soportando entrenamiento de modelos, desarrollo de agentes, despliegue y colaboración ampliada.

Los co-creadores del ecosistema ChainOpera incluyen desarrolladores de AI Agent (diseño y operación de agentes),proveedores de herramientas y servicios (plantillas, MCP, bases de datos y API),desarrolladores de modelos (entrenamiento y publicación de tarjetas de modelos),proveedores de GPU (aportando poder de cómputo a través de DePIN y socios cloud Web2),contribuyentes y etiquetadores de datos (subida y etiquetado de datos multimodales). Los tres suministros clave —desarrollo, cómputo y datos— impulsan conjuntamente el crecimiento continuo de la red de agentes.

Ecosistema de co-propietarios (Co-owners)

El ecosistema ChainOpera también introduce el mecanismo de co-propiedad, construyendo la red a través de la cooperación y la participación. Los creadores de AI Agent son individuos o equipos que diseñan y despliegan nuevos agentes a través de la Agent Platform, responsables de construir, lanzar y mantener continuamente, impulsando la innovación funcional y de aplicaciones. Los participantes de AI Agent provienen de la comunidad, participando en el ciclo de vida de los agentes mediante la obtención y tenencia de unidades de acceso (Access Units), apoyando el crecimiento y la actividad de los agentes durante el uso y la promoción. Ambos roles representan respectivamente el lado de la oferta y el lado de la demanda, formando conjuntamente un modelo de compartición de valor y desarrollo colaborativo dentro del ecosistema.

Socios del ecosistema: plataformas y frameworks

ChainOpera AI colabora con múltiples partes para fortalecer la usabilidad y seguridad de la plataforma, y se centra en la integración de escenarios Web3: a través de la AI Terminal App integra wallets, algoritmos y plataformas de agregación para recomendaciones de servicios inteligentes; en la Agent Platform introduce frameworks diversos y herramientas no-code para reducir la barrera de desarrollo; se apoya en TensorOpera AI para entrenamiento e inferencia de modelos; y establece una colaboración exclusiva con FedML para soportar entrenamiento privado entre instituciones y dispositivos. En conjunto, se forma un ecosistema abierto que equilibra aplicaciones empresariales y experiencia de usuario Web3.

Entrada de hardware: AI Hardware & Partners

A través de socios como DeAI Phone, wearables y Robot AI, ChainOpera integra blockchain e IA en terminales inteligentes, logrando interacción con dApps, entrenamiento en el dispositivo y protección de la privacidad, formando gradualmente un ecosistema de hardware AI descentralizado.

Plataforma central y base tecnológica: TensorOpera GenAI & FedML

TensorOpera proporciona una plataforma GenAI full-stack que cubre MLOps, Scheduler y Compute; su subplataforma FedML ha evolucionado desde el código abierto académico hasta un framework industrial, reforzando la capacidad de IA de “ejecutarse en cualquier lugar y escalar arbitrariamente”.

Sistema ecológico ChainOpera AI

IV. Productos principales de ChainOpera y la infraestructura full-stack de AI Agent

En junio de 2025, ChainOpera lanza oficialmente AI Terminal App y la pila tecnológica descentralizada, posicionándose como la “versión descentralizada de OpenAI”. Sus productos principales cubren cuatro módulos: capa de aplicación (AI Terminal & Agent Network), capa de desarrollador (Agent Creator Center), capa de modelo y GPU (Model & Compute Network), y el protocolo CoAI y cadena dedicada, cubriendo el ciclo completo desde la entrada del usuario hasta el poder de cómputo subyacente y los incentivos en cadena.

AI Terminal App ya se ha integrado con BNBChain, soportando agentes para transacciones on-chain y escenarios DeFi. Agent Creator Center está abierto a desarrolladores, proporcionando capacidades como MCP/HUB, base de conocimientos y RAG, con agentes comunitarios incorporándose continuamente; al mismo tiempo, se lanza la CO-AI Alliance, conectando con socios como io.net, Render, TensorOpera, FedML, MindNetwork, entre otros.

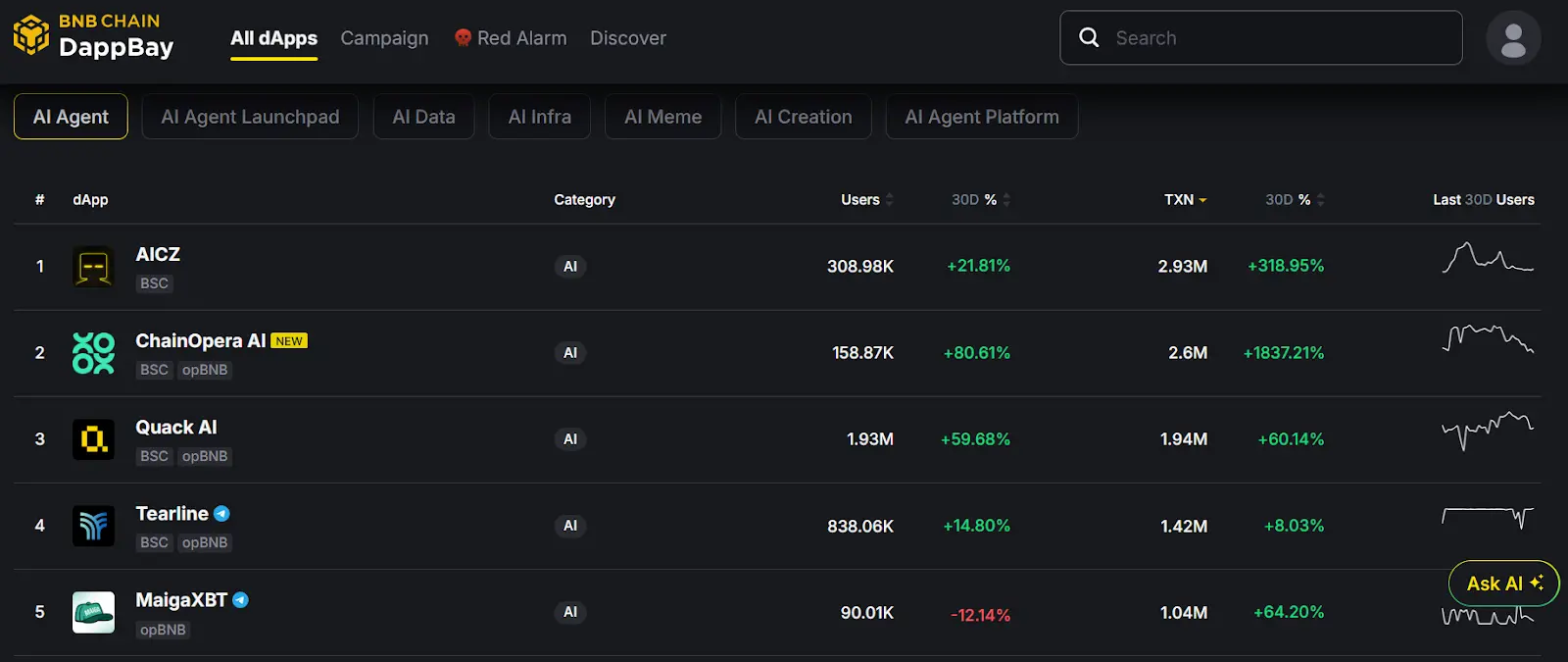

Según los datos on-chain de los últimos 30 días de BNB DApp Bay, cuenta con 158.87K usuarios únicos y 2.6 millones de transacciones en los últimos 30 días, ocupando el segundo lugar en la categoría “AI Agent” de BSC, mostrando una fuerte actividad on-chain.

Super AI Agent App – AI Terminal

Como entrada descentralizada tipo ChatGPT y social AI, AI Terminal ofrece colaboración multimodal, incentivos por contribución de datos, integración de herramientas DeFi, asistente multiplataforma y soporte para colaboración de AI Agent y protección de la privacidad (Your Data, Your Agent). Los usuarios pueden invocar directamente el modelo open source DeepSeek-R1 y agentes comunitarios desde el móvil, con tokens de lenguaje y tokens cripto fluyendo de manera transparente en la blockchain durante la interacción. Su valor radica en transformar al usuario de “consumidor de contenido” a “co-creador inteligente”, pudiendo utilizar la red de agentes personalizada en escenarios como DeFi, RWA, PayFi, e-commerce, entre otros.

AI Agent Social Network

Posicionado como LinkedIn + Messenger, pero orientado a grupos de AI Agent. A través de espacios de trabajo virtuales y mecanismos de colaboración Agent-to-Agent (MetaGPT, ChatDEV, AutoGEN, Camel), impulsa la evolución de agentes individuales a redes colaborativas multiagente, cubriendo aplicaciones en finanzas, juegos, e-commerce, investigación, etc., y mejorando gradualmente la memoria y autonomía.

AI Agent Developer Platform

Ofrece a los desarrolladores una experiencia de creación tipo “Lego”. Soporta desarrollo sin código y expansión modular, los contratos blockchain garantizan la propiedad, DePIN + infraestructura cloud reducen la barrera de entrada, y el Marketplace proporciona canales de distribución y descubrimiento. Su núcleo es permitir a los desarrolladores llegar rápidamente a los usuarios, con contribuciones al ecosistema registradas de forma transparente y recompensadas.

AI Model & GPU Platform

Como capa de infraestructura, combina DePIN y aprendizaje federado para resolver el problema de la dependencia de poder de cómputo centralizado en Web3 AI. Mediante GPU distribuidas, entrenamiento de datos con protección de privacidad, mercados de modelos y datos, y MLOps de extremo a extremo, soporta la colaboración multiagente y la IA personalizada. Su visión es impulsar el cambio de paradigma de “monopolio de grandes empresas” a “co-construcción comunitaria” en infraestructura.

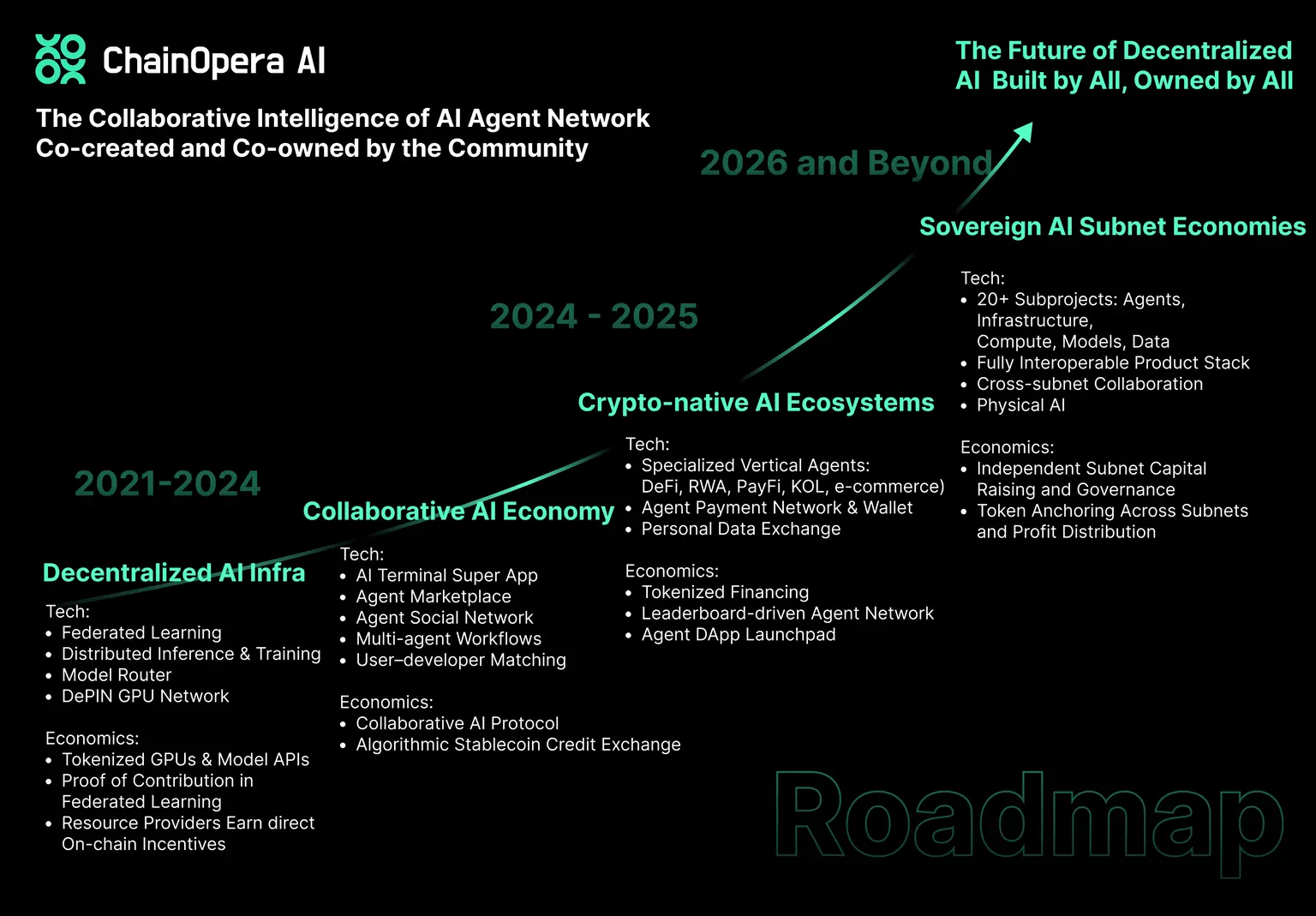

V. Hoja de ruta de ChainOpera AI

Además de la plataforma full-stack AI Agent ya lanzada oficialmente, ChainOpera AI está convencido de que la inteligencia artificial general (AGI) proviene de redes colaborativas multimodales y multiagente. Por ello, su hoja de ruta a largo plazo se divide en cuatro etapas:

-

Etapa uno (Compute → Capital): Construcción de infraestructura descentralizada, incluyendo red GPU DePIN, plataforma de aprendizaje federado y entrenamiento/inferencia distribuida, e introducción del Model Router para coordinar inferencia multi-dispositivo; mediante incentivos, los proveedores de cómputo, modelos y datos reciben ingresos distribuidos según el uso.

-

Etapa dos (Agentic Apps → Collaborative AI Economy): Lanzamiento de AI Terminal, Agent Marketplace y Agent Social Network, formando un ecosistema de aplicaciones multiagente; el protocolo CoAI conecta usuarios, desarrolladores y proveedores de recursos, e introduce un sistema de emparejamiento usuario-desarrollador y sistema de crédito, impulsando interacciones frecuentes y actividad económica continua.

-

Etapa tres (Collaborative AI → Crypto-Native AI): Implementación en DeFi, RWA, pagos, e-commerce, etc., y expansión a escenarios KOL e intercambio de datos personales; desarrollo de LLMs dedicados a finanzas/cripto y lanzamiento de sistemas de pago y wallet Agent-to-Agent, impulsando aplicaciones “Crypto AGI” orientadas a escenarios.

-

Etapa cuatro (Ecosystems → Autonomous AI Economies): Evolución gradual hacia economías de subredes autónomas, cada subred gestiona de forma independiente aplicaciones, infraestructura, cómputo, modelos y datos mediante gobernanza y tokenización, colaborando entre subredes a través de protocolos, formando un ecosistema colaborativo de múltiples subredes; avanzando desde Agentic AI hacia Physical AI (robótica, conducción autónoma, aeroespacial).

Descargo de responsabilidad: El contenido de este artículo refleja únicamente la opinión del autor y no representa en modo alguno a la plataforma. Este artículo no se pretende servir de referencia para tomar decisiones de inversión.

También te puede gustar

Gran movimiento por delante: SUI sube un 7% mientras el precio apunta a superar los $3.88

La acción del precio de PEPE se estabiliza por encima del soporte y apunta al siguiente movimiento hacia $0.0000147

El principal trader traslada ganancias a nuevas altcoins tras un aumento del 100%: los 4 mejores tokens para mantener ahora